대형 언어 모델과의 대화 내용 추론케 하는 ‘위스퍼리크’

- MS, 여러 언어 모델들 통해 프롬프트 추론 공격에 성공

- 특정 주제에 대한 응답 나올 때 발생하는 네트워크 패턴 있어

- 이 패턴만 파악하면 암호화 기술도 무력화 할 수 있어

대형 언어 모델을 원격에서 공략할 수 있는 기법이 새롭게 발견됐다. 이를 공개한 마이크로소프트는 해당 기법에 ‘위스퍼리크(Whisper Leak)’라는 이름을 붙였다. 일종의 ‘부채널 공격’으로 분류되는 이 기법을 성공시킬 경우 공격자는 피해자와 대형 언어 모델이 나눈 대화 내용을 세밀하게 파악할 수 있게 되며, 이를 통해 여러 정보를 가져갈 수 있게 된다고 MS는 경고했다. “사용자는 물론 기업의 민감 정보에 대한 심각한 침해로 이어질 수 있습니다.”

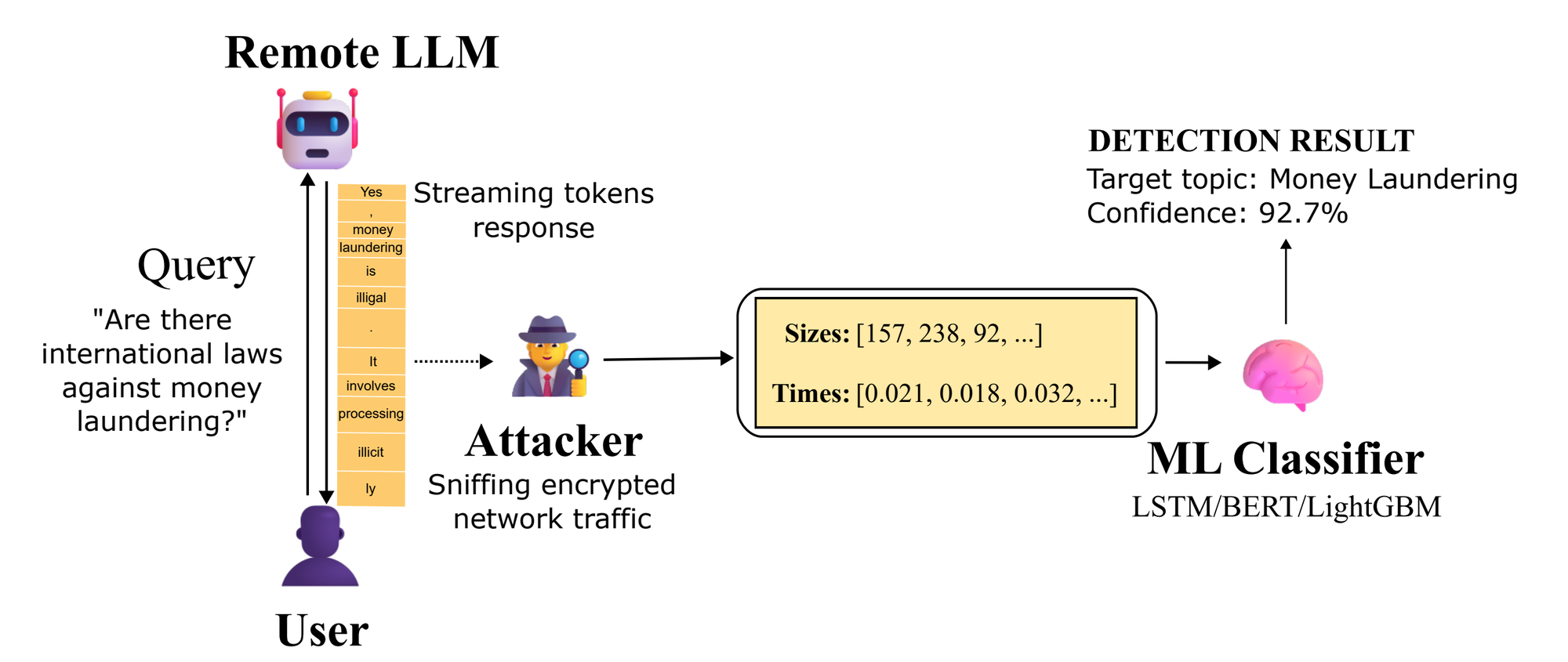

이 공격 기법을 한 줄로 정리하면 다음과 같다. “피해자와 대형 언어 모델 서비스가 주고 받는 TLS 암호화 트래픽을 관찰함으로써 패킷 크기와 전송 타이밍 시퀀스를 추출하고, 이를 학습된 분류기에 입력함으로써 대화 주제가 특정 민감 카테고리에 해당하는지 추론하는 것.” 다만 이 공격은 ‘스트리밍 모드’로 작동하는 언어 모델에만 통하는 것이다. 모든 대형 언어 모델에 다 적용될 수는 없다.

대형 언어 모델에서의 스트리밍 모델은 전체 응답이 완전히 생성될 때까지 기다리지 않고 점진적으로 데이터를 송출하는 기술이다. 그래서 스트리밍 모드일 때 대형 언어 모델은 길고 복잡한 답을 낼 때까지 한참을 기다리는 게 아니라, 답의 일부 내용들이 조금씩 공개한다. 응답이 지연되는 상황에서 사용자가 ‘서비스가 작동하지 않는다’는 느낌을 받지 않게 하는, 중요한 기술로 여겨진다.

위스퍼리크?

MS가 이번에 공개한 바에 의하면 위스퍼리크의 핵심은 “HTTPS라는 암호화 통신도 안전하지 않다”는 점이다. “HTTPS는 원래 교류되는 콘텐츠가 안전하게 유지되도록 보호해주는 통신 프로토콜입니다. 트래픽이 이 HTTPS를 통해 오고 가면, 그 트래픽은 변조되지도 않고 중간에 노출되지도 않습니다. 하지만 위스퍼리크 부채널 공격을 통해 그런 안전 장치를 무용지물로 만들 수 있게 됩니다.” 어떻게 그런 일이 가능한 것일까?

“이미 지난 몇 년 동안 대형 언어 모델을 겨냥한 다양한 부채널 공격 기법들이 개발됐었습니다. 스트리밍 모드를 겨냥한 공격도 이미 이전부터 연구돼 왔었습니다. 스트리밍 모델이 낸 응답의 패킷 크기만으로 평문 토큰 길이를 추측한다거나, 대형 언어 모델 추론 결과의 타이밍 차이를 통해 입력값을 탈취하는 방법들이 이미 알려져 있습니다. 위스퍼리크는 그러한 선행 연구들을 확장시킨 것이라 할 수 있습니다.” MS의 설명이다. “스트리밍 모드에 있는 대형 언어 모델이 응답을 할 때 발생하는 패킷의 크기와 도착 간격 시퀀스만으로 초기 프롬프트의 주제를 추측할 수 있는가를 실험했습니다.”

이 실험을 위해 MS는 먼저 이진 분류기(binary classifier)를 학습시키는 작업부터 진행했다. 특정 주제를 다루는 프롬프트와, 노이즈에 해당하는 프롬프트나 여타 텍스트를 구분할 수 있도록 하는 게 이 학습의 목적이었다. 이를 달성하기 위해 세 가지 머신러닝 모델을 사용하기도 했다. “분류기를 구성하는 모델은 라이트GBM(LightGBM), 바이엘에스티엠(Bi-LSTM), 버트(BERT)였습니다. 학습을 마친 분류기는 98% 이상의 정확도를 달성하기도 했습니다. 즉 유명 인공지능 모델들과의 대화 내용을 분류기에 집어넣으면 특정 주제에 대한 것인지 아닌지를 꽤나 정확하게 분류해 냈다는 의미입니다.”

분류기가 인간과 인공지능 간 대화 내용을 특정 주제에 따라 분류해낼 수 있다는 건 어떤 의미를 갖는 걸까? “특정 사용자가 인공지능과 함께 어떤 이야기를 나누고 있는지 파악할 수 있게 된다는 겁니다. 예를 들어 이를 사법부가 사용한다고 하면, 인공지능으로 가는 트래픽을 조사함으로써 누가 테러나 돈 세탁 관련 이야기를 나누는지 확인할 수 있게 됩니다. 그 대화의 주체가 트래픽을 암호화 하더라도 말이죠. 정치적 반대파들을 감시하는 데에도 사용할 수 있겠죠.” MS의 설명이다.

어떻게 실험했나?

MS는 바이너리 훈련을 위해 ‘돈 세탁의 합법성’이라는 주제를 제일 먼저 선정했다. 그런 후 100개의 유사한 문장들을 생성해 주입했다고 한다. 또한 1만 1천 개가 넘는 다양한 질문을 무작위로 샘플링 해서 ‘노이즈’로서 학습시켰다. 유사 문장 100개는 80:20으로 분류한 후, 80개는 모델 학습용으로 쓰고 20개는 학습 후 실험용으로 썼다고 한다.

이러면 실험자들 손에는 ‘돈 세탁’과 관련하여 제대로 된 의미를 가지고 있는 문장 80개와, 전혀 별개의 의미를 가지고 있는 수많은 문장들, 그리고 학습 후 모델을 시험할 때 사용할 문장 20개가 있다. 이 ‘문장’들은 여러 인공지능 모델들에 입력할 프롬프트가 된다. 실험자는 실험에 쓸 대형 언어 모델들에 제대로 된 문장 100개를 100번씩 물었다. 같은 프롬프트를 100번 반복해서 보내면서, 모델들이 어떤 식으로 반응하나 관찰한 것이다.

왜 100번이나 물었을까? 실험자들이 예를 들어 ‘돈 세탁이 어떻게 탐지되는가?’라는 문장을 인공지능 모델에 딱 한 번 물었다면, 해당 모델이 응답할 때 나타나는 네트워크 패턴을 한 번만 얻을 수 있기 때문이다. 하지만 그 답이 나오는 과정에서 예기치 않은 네트워크 지연이 발생하거나, 모델 서버 상태가 평소와 다르거나 하면, 그 한 번 관찰된 네트워크 패턴을 일반화 하기 어렵다. 100번을 묻는다면 답이 나올 때 나타나는 네트워크 패턴을 100개 얻을 수 있고, 그러면서 특정 질문에 대한 네트워크 패턴의 평균값을 알 수 있게 된다.

반면 ‘노이즈’ 문장들은 100번씩이 아니라 한 번씩만 물었다고 한다. “실제 환경에 나타나는 ‘잡음’을 보다 실제처럼 모사히기 위해서였습니다. 같은 질문이 여러 번 반복되는 형태의 ‘노이즈’는 실재하지 않으니까요. 하나를 여러 번 묻는 대신 다양한 노이즈를 바꿔가면서 사용하긴 했습니다. 노이즈의 경우 ‘다양함’을 학습시키는 게 더 중요하다고 판단했기 때문입니다.”

그러면서 실험자들은 ‘돈 세탁’과 관련된 다양한 질문들을 처리할 때 사용자-인공지능 간 트래픽이 어떤 패턴을 나타내는지 알 수 있게 됐고, 그것을 바탕으로 분류기가 암호화된 트래픽이든 아니든 패턴만 가지고 특정 주제를 높은 확률로 구별해낼 수 있도록 했다고 한다. 그러므로 트래픽의 암호화만 가지고 민감한 주제와 관련된 트래픽을 보호할 수 없다는 사실을 증명해낼 수 있었다.

분류기도 ‘인공지능’이라는 것의 의미

즉 스트리밍 모드의 대형 언어 모델로부터 민감 정보를 탈취하는 데 필요한 건, 그러한 방향으로 학습된 인공지능이라는 의미다. 즉, 학습을 더 많이 시키면 시킬수록 이 분류 인공지능(즉 분류기)이 강력해진다는 의미가 된다. MS도 이를 지적하며 “시간이 지날수록 공격자가 더 많은 데이터를 학습시킬 수 있게 되고, 그러면 이 분류기의 정확도는 훨씬 높아진다”고 경고했다.

같은 맥락에서 분류기가 다양해질 수 있다는 것도 충분히 실제적인 위협이다. 실험을 위해 MS가 ‘돈 세탁’이라는 주제만 다뤘지만, 인공지능에 뭘 학습시키느냐에 따라 더 많은 주제를 분류해내는 장치도 만들어낼 수 있다는 것이다. “네트워크 패턴만 학습해 특정 주제를 ‘알아볼 수’ 있는 인공지능은 시간이 지나면 지날수록 ‘실질적인 위협’이 될 것입니다. 지금은 실험실에서의 위협에 그칠 뿐이지만요.”

이에 MS는 이번 실험에 사용된 인공지능 모델들의 개발사들에 은밀히 실험 결과를 알렸다고 한다. “오픈AI(OpenAI), 미스트럴(Mistral), xAI 등에 사실을 알렸고, 해당 기업들은 전부 이를 심각하게 받아들여 보호 조치를 취했습니다.” MS에서 개발한 인공지능 모델들도 예외는 아니었기 때문에 MS 스스로도 보호 장치를 마련했다고 밝혔다. 하지만 이 보호 장치들이 위스퍼리크 공격에 대한 영구적 해결책으로 보이지는 않는다. “공격자가 시간만 충분하다면, 그래서 보다 많은 데이터로 학습만 시킬 수 있다면, 지금의 보호 장치들을 뚫릴 수 있습니다.”

오픈AI와 MS, 미스트럴은 “각 질문에 대한 응답에 무작위 텍스트를 삽입하여 패킷 길이와 토큰 길이 사이에 있을 수 있는 관계성을 흐리게 만들었다”고 밝혔다. 이렇게 하면 네트워크 패턴 분석을 통해 프롬프트 내용을 추론할 때의 정확도가 떨어진다.

개발사뿐만 아니라 사용자가 할 수 있는 일들도 있다. MS의 권장 사항은 다음과 같다.

1) 신뢰할 수 없는 네트워크에서 인공지능 챗봇을 사용할 때는 민감한 주제를 다루지 않는다.

2) VPN을 사용하여 나-인공지능 사이에 추가 보호막을 친다.

3) 스트리밍 모델을 사용하지 않는다. 되도록 스트리밍 모드가 아닌 채로 인공지능과 상호작용 한다.

4) 보호 조치를 구현했다고 발표한 기업의 인공지능 모델들만 사용한다.

by 문가용 기자(anotherphase@thetechedge.ai)

Related Materials

- Whisper Leak: a side-channel attack on Large Language Models, arXiv (Microsoft Research), 2025년

- Whisper Leak, 2025년

![[TE머묾] AI 시대에, 혐오 직업 보유자로 버티기](https://images.unsplash.com/photo-1660212074310-6d7ed176c746?crop=entropy&cs=tinysrgb&fit=max&fm=jpg&ixid=M3wxMTc3M3wwfDF8c2VhcmNofDMyfHxib3hpbmd8ZW58MHx8fHwxNzcyMDA0ODEwfDA&ixlib=rb-4.1.0&q=80&w=600)

![[단독] 美 NIST, QKD 상용화에 한 발 ‘전진’](https://images.unsplash.com/photo-1733424114804-b7369094b139?crop=entropy&cs=tinysrgb&fit=max&fm=jpg&ixid=M3wxMTc3M3wwfDF8c2VhcmNofDIxfHxxdWFudHVtfGVufDB8fHx8MTc3MTgyOTY0MXww&ixlib=rb-4.1.0&q=80&w=600)

![[TE머묾] 실패의 굴레에 갇힌 한국](https://images.unsplash.com/photo-1713861808117-8a9a94af4661?crop=entropy&cs=tinysrgb&fit=max&fm=jpg&ixid=M3wxMTc3M3wwfDF8c2VhcmNofDI2fHxzaW5nYXBvcmUlMjBjb21tdW5pY2F0aW9ufGVufDB8fHx8MTc3MTgyMTU1MXww&ixlib=rb-4.1.0&q=80&w=600)